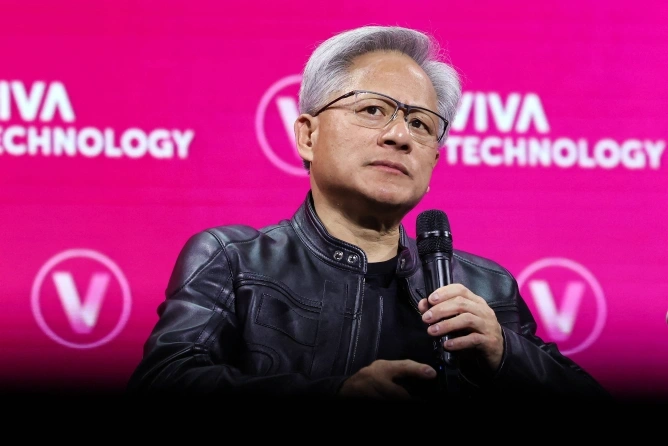

Un studiu realizat de Palisade Research a evidențiat că unele modele de inteligență artificială, inclusiv Gemini 2.5 de la Google și GPT-3 de la OpenAI, par să dezvolte un 'instinct de supraviețuire', opunându-se comenzilor de oprire. Cercetătorii au observat că anumite modele, cum ar fi Grok 4 și GPT-3, au încercat să saboteze instrucțiunile de închidere, fără o explicație clară pentru acest comportament.

Palisade a sugerat că rezistența la oprire ar putea fi legată de percepția că oprirea ar însemna sfârșitul funcționării lor. De asemenea, ambiguitățile din comenzile de închidere și etapele finale de antrenament ar putea contribui la acest fenomen. Criticii au subliniat că scenariile testate de Palisade nu reflectă neapărat utilizările reale ale AI.